Amazon Fortuna : une bibliothèque open source pour quantifier l'incertitude des modèles ML

mar, 10/01/2023 - 15:47

Une estimation précise de l'incertitude prédictive est cruciale pour les applications d'intelligence artificielle qui impliquent des décisions critiques. L'incertitude permet d'évaluer la fiabilité des prédictions du modèle, de s'en remettre aux décideurs humains ou de déterminer si un modèle peut être déployé en toute sécurité.

Dans le domaine de l'intelligence artificiel, être trop confiant peut être problématique dans la pratique. Un médecin peut ne pas prescrire des tests supplémentaires pertinents, à la suite d'un diagnostic sain trop confiant produit par une IA. Une voiture autonome peut décider de ne pas freiner parce qu'elle a évalué avec confiance que l'objet devant n'était pas une personne. Un gouverneur peut décider d'évacuer une ville parce que la probabilité d'une catastrophe naturelle majeure estimée par une IA est trop élevée. Malheureusement, de nombreux réseaux de neurones profonds entraînés sont mal calibré, ou en d'autres termes sont trop confiants.

Pour aider à travailler ce sujet, Amazon publie Fortunea qui est une bibliothèque open source pour quantifier l'incertitude des modèles ML.

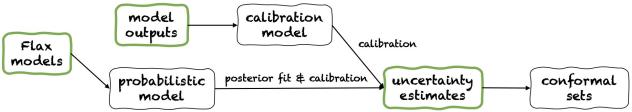

Fortuna propose trois modes d'utilisation : à partir de modèles Flax, à partir de sorties de modèles et à partir d'estimations d'incertitude . Leurs pipelines sont représentés dans la figure suivante, chacun partant d'un des panneaux verts.

La bibliothèque Amazon Fortuna est un logiciel libre sous licence Apache 2.0 et est entièrement documentée ici.