lun, 04/06/2012 - 11:47

Dans un écosystème de plus en plus data-centric, la maitrise de la qualité de la donnée devient un enjeu crucial, voire déterminant du leadership. Mais pour devenir un avantage concurrentiel, celle-ci doit être conçue dans une approche préventive. Par Daliane Calvani, Manager Pôle Conseil Ysance.

Il y a quelques mois, Free Mobile a rencontré des difficultés à envoyer les cartes SIM à des milliers de nouveaux clients. La cause ? Le champ « adresse » du formulaire d’abonnement sur internet n’était pas adapté. Si le coût de ce ratage n’est pas connu, les conséquences en matière de réputation et de développement commercial sont fortement dommageables. Cet épisode est le dernier exemple emblématique d’une longue liste de revers commerciaux imputables à la seule qualité des données.

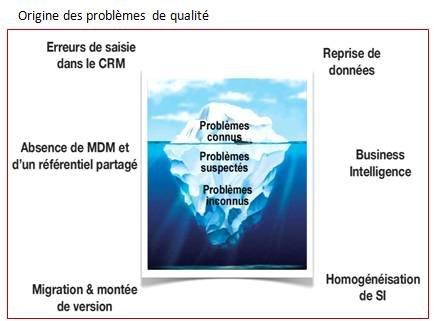

Au cœur de cet enjeu stratégique, les entreprises sont devenues « data-centric ». Et si l’ensemble des processus métiers et des couches décisionnelles repose sur la qualité des flux d’informations qui y circulent, le CRM est une des applications les plus confrontées à ce déluge de données brutes. Entre les noms mal orthographiés, les codes produits incorrects, les champs incomplets, les informations tronquées, les doublons, les saisies dans un mauvais champ, les sources de dégradation de la donnée sont nombreuses et influent directement sur l’efficacité commerciale de l’entreprise.

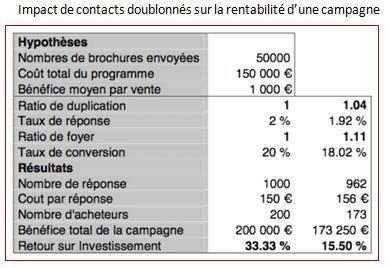

Prenons un exemple (voir tableau) :une entreprise envoie 50 000 brochures à une base de prospects dupliquée à hauteur de 4%. Compte tenu du coût total du programme, estimé à 150 000€, le retour sur investissement de l’opération se limitera à 15,5%, contre 33,3% si l’envoi avait été effectué vers une base de contacts non dupliquée. L’effet de levier que procurent des données de qualité peut donc s’avérer un avantage concurrentiel décisif. A l’inverse, l’absence de confiance dans la donnée implique une perte de confiance dans le système de pilotage de nature à bloquer la prise de décision. Aux Etats-Unis, une étude a estimé le coût de la mauvaise qualité des données à plus de 600 milliards de dollars chaque année pour les entreprises.

Les projets de Master Data Management (MDM), qui visent à définir et distribuer une vision fiable et harmonisée des données référentielles d’un système d’information, se sont certes multipliés depuis quelques années. Mais ces derniers ne servent pas à grand-chose si la qualité de ces données n’est pas sécurisée en amont. Cela reviendrait à construire une maison sur des fondations en sable. C’est là qu’interviennent les projets de Data Quality, qui visent à s’assurer de la qualité des données au sein d’une organisation. Ils sont un préalable à toute mise en place de projets de MDM, dont ils sont un facteur-clé de succès. Ils sont en quelque sorte ce qu’est la médecine chinoise, préventive et conçue a priori, à la médecine occidentale, plus brutale car intervenant a posteriori.

Pour autant, la qualité de la donnée est rarement une priorité pour les entreprises françaises, contrairement à leurs consœurs outre-Atlantique. Trop souvent encore, les questions de gestion et de qualité des données se posent tardivement : sur un constat d’échec, et non dans un objectif de performance, au coup par coup, et non dans une démarche globale de long terme. Pour quelles raisons ?

Le coût ? Certes, le prix des logiciels de Data Quality est encore élevé. En cause, l’inexistence de solutions open source - hors outil de diagnostic (profiling) - et la complexité des algorithmes. Surtout, les projets de Data Quality sont effectués au pire moment, lorsque les dégâts sur les bases de données sont tellement importants qu’ils paralysent l’organisation, impliquant des coûts élevés. Le principal frein à la nécessaire montée en puissance de ces projets est donc essentiellement culturel. Reste que le marché tend à s’ouvrir… L’écosystème technique autour de la donnée se simplifie, entrainant de fait les éditeurs à revoir leur tarification à la baisse. Cet environnement favorable, jumelé à une démarche préventive des entreprises, rend les offres de Data Quality beaucoup plus abordables.

La méthodologie ?

Transversaux, les projets de Data Quality se déploient en cinq étapes successives :

1- Evaluation de l’étendue des dégâts

2- En corriger les causes

3- Contrôler le parcours de données

4- Corriger les erreurs existantes

5- Mesurer la mise en qualité

C’est ce dernier stade qui permet au final de pérenniser la qualité des données. Pour être efficace, cette phase vise à s’assurer du respect d’indicateurs-clés : duplication (quelles sont les données répétées ?), standardisation (quelles sont les données saisies, stockées ou affichées dans un format standard ?), intégralité (toutes les données nécessaires sont-elles disponibles ?), exactitude (les valeurs représentent-elles la réalité ?), interprétabilité (les données sont-elles compréhensibles par les utilisateurs ?) et opportunité (l’âge des données est-il conforme aux besoins métiers ?).

Le ROI ? Là encore, il s’agit de nuancer et de placer la problématique dans une logique prédictive. Car ne rien faire peut s’avérer bien pire… et plus cher. Certes, il n’est pas simple de mesurer le ROI à court terme d’un projet de Data Quality, tant la donnée est omniprésente et les impacts de la qualité diffus à toutes les applications de l’entreprise. Mais si l’on inverse le raisonnement, que se passe-t-il si les données sont laissées sans gestion ni surveillance ? Si, face au déluge de données que connaissent aujourd’hui les entreprises, celles-ci sont erronées, tronquées ou redondantes ? Le manque à gagner est conséquent et les gains générés suite à l’optimisation de la qualité de données peuvent faire une différence décisive vis-à-vis des concurrents.

L’enjeu business qui se cache derrière le Data Quality est donc colossal. Les sociétés leaders – Google, Facebook… - et les grands pure-players américains l’ont bien compris : ils veillent sur leurs données comme le lait sur le feu. Car, dans un environnement data-centric qui ne cesse de se développer, les promesses du Data Quality sont à la hauteur de la complexité du projet : productivité, réduction des coûts, efficacité des campagnes marketing, meilleure gestion de la relation-client, etc.

C’est d’ailleurs ce dernier point qui fera très certainement décoller le marché du Data Quality. Car avec la suprématie de réseaux sociaux et l’hégémonie du « consomm’acteur », la satisfaction du client est devenu un facteur différenciant et un moteur de la réussite de l’entreprise. A l’instar du marché américain, le marché français du Data Quality se développera. Reste à savoir à quelle vitesse…

Daliane Calvani, Manager Pôle Conseil Ysance

A propos de l'auteur