Google Cloud : nouveaux TPU et nouvelles instances Axion

ven, 07/11/2025 - 08:54

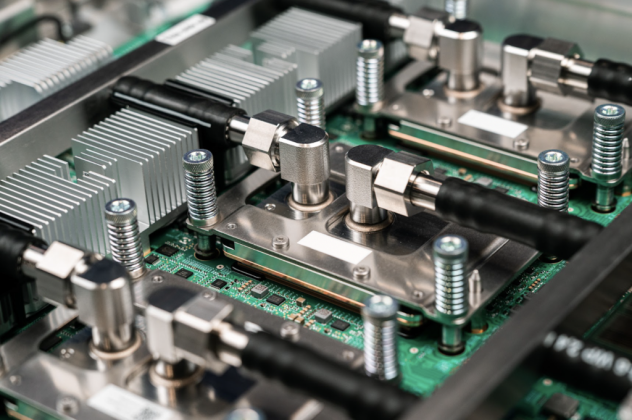

Goolge conçoit une partie du hardware de ses datacenters et particulièrement les composants clés. Le dernier exemple en date est l'annonce de la nouvelle génération de composants TPU : les Ironwood. Ce sont des accélérateurs dédiés à l'IA. Ils sont taillés pour l'entraînement des modèles LLM et l'inférence à faible latence. Dans le même temps, Google Cloud annonce de nouvelles instances basées sur Axion : les N4A. Axion est une gamme de processeurs développés par Google, utilisant l'architecture Arm.

Outre l'instance N4A, Google annonce aussi C4A, une instance bare metal qui sera bientôt disponible.

Les nouvelles instances (à venir ou disponibles) :

- N4A : jusqu'à 64 vCPU, 512 Go de RAM DDR5, réseau 50 Gbps.

- C4A Metal : bare metal pour les charges spécifiques comme les hyperviseurs et les développements Arm. Jusqu'à 96 vCPU, 768 Go de RAM DD5, réseau 100 Gbps

- C4A : jusqu'à 72 vCPU, 576 Go de RAM DD5, réseau 100 Gbps, SSD jusqu'à 6 To de stockage local

Par ces annonces, Google continue à renforcer son offre cloud. En résumé :

- Ironwood : le TPU de septième génération de Google. Ironwood est spécialement conçu pour les charges de travail les plus exigeantes : de l'entraînement de LLM et l'apprentissage par renforcement complexe à l'inférence IA à haut volume et faible latence et au service de modèles. Il offre des performances plus de quatre fois supérieures à celles de la génération précédente, tant pour les charges de travail d'entraînement que d'inférence, ce qui fait d'Ironwood notre silicium personnalisé le plus puissant et le plus économe en énergie à ce jour. Pas encore disponible

- Nouvelles instances basées sur Axion Arm : diisponible en avant-première.

- Cluster Director dans Google Kubernetes Engine : les clients TPU peuvent désormais bénéficier des fonctionnalités de Cluster Director dans Google Kubernetes Engine. Cela inclut la maintenance avancée et la reconnaissance de la topologie, ainsi que la maintenance avancée pour une planification intelligente et des clusters hautement résilients.

- Améliorations de MaxText : Le framework LLM open source haute performance a été amélioré, afin de faciliter la mise en œuvre des dernières techniques d'optimisation de l'entraînement et de l'apprentissage par renforcement, telles que le Supervised Fine-Tuning (SFT) et le Generative Reinforcement Policy Optimization (GRPO).