Ollama : une app pour exécuter les LLM localement

jeu, 03/07/2025 - 17:19

L'application Ollama permet d'exécuter localement des LLM. L'app supporte Gemma 3, QwQ, DeepSeek, Llama, Phi 4, Mistal, Granite, etc. Les LLM vont du très gros modèles de 245 Go aux modèles plus légers de 2,5 Go. L'application importe aussi les modèles GGUF dans le modelfil.

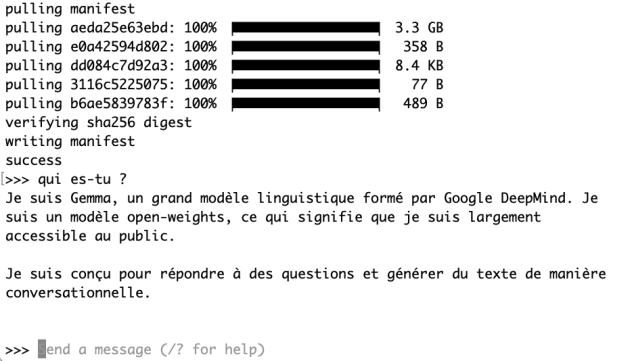

Ollama met d'abord en place un serveur pour ensuite récupérer le LLM et l'exécuter localement. Il faut donc prévoir la place nécessaire. Ollama est disponible sur macOS et Windows en version 0.9.5. Pour aller plus vite, on utilisait le Terminal pour exécuter les LLM : ollama run gemma3:1b

On peut ainsi utiliser en quelques minutes le modèle de son choix sans passer par un service distant.

GitHub : https://github.com/ollama/ollama

Commentaires

Et il existe une interface graphique qui va rendre votre Ollama beaucoup plus "user friendly", façon ChatGPT, Claude et consors...

https://korben.info/open-webui-nouvelle-interface-graphique-ollama.html